周周升级月月上新的AI芯片都是啥:5分钟搞明白AI芯片

一键生成会议纪要,一句话创建AI应用。曾经费时费力的任务现在在人工智能的帮助下变得轻而易举。

AI的“魔力”不仅仅体现在这些日常办公场景中,它也在改变我们的生活方式。从智能推荐系统为我们提供个性化的娱乐选择,到自动驾驶技术让出行更安全、便捷,人工智能无疑给我们的生活带来了前所未有的便利和效率。

然而,这一切“魔法”的背后,都有一个不可或缺的“魔术师”——AI芯片。它就像人工智能的“大脑”,处理海量数据并驱动各种复杂算法。

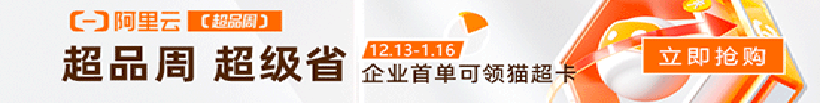

为了应对AI应用对硬件性能的更高要求,科技巨头纷纷推出自己的AI芯片,例如英伟达的H200、谷歌的TPU,以及英特尔、AMD、高通和苹果集成到计算机产品中的NPU。

AI芯片现已成为科技巨头竞相开发的重点产品。每天都有大量的新闻和最新进展报告。今天我就带大家来看看这些AI芯片。

GPU:NVIDIA H100/200、AMD Instinct MI300、Intel Gaudi 3

提到AI,我们就会想到GPU。看来GPU已经和AI结下了很深的缘分了!确实,在人工智能(AI)领域,图形处理单元(GPU)具有先天的优势。

GPU高效的并行处理能力使其成为AI算法中数学计算的理想选择,特别适合处理AI中大量的矩阵运算和深度学习任务。相比于中央处理器(CPU),GPU能够更快地执行复杂的计算任务,从而大幅提高AI模型的训练和推理速度。

此外,GPU的并行架构还使其能够同时处理多个数据块,这对于处理AI中的大规模数据集至关重要。在深度学习领域,GPU的这种能力被广泛用于加速神经网络的训练和推理过程,从而显着提高AI应用的性能和效率。

不仅如此,GPU还提供高度优化的库和工具,让开发者更轻松地实现高效的AI算法。这些库和工具为人工智能研究人员和工程师提供了强大的支持,使他们能够更快地开发高效的人工智能应用。

目前比较有代表性的产品有NVIDIA H100/200、AMD Instinct MI300等,由于谷歌、微软等大型科技公司在云端部署了大量GPU,提供强大的算力支持,NVIDIA已经成功迈入万亿- 美元市值俱乐部及其GPU。

FPGA:AMD Versal AI Edge

与CPU、GPU相比,FPGA对于普通用户来说显得比较陌生。简单来说,FPGA相当于一块“通用”芯片。它可以根据需要重新编程以执行各种任务。

这意味着,如果需要执行特定的计算任务或处理特定的数据,可以通过编程“定制”FPGA上的硬件逻辑,使其能够以最高效的方式完成工作。就像您可以根据需要更换瑞士军刀上的工具一样。

因此,FPGA在需要高度定制化和灵活性的应用中表现良好,使得FPGA能够适应不同的AI需求,通过硬件级的优化来提升性能,常见于深度学习加速、视频图像处理、自然语言处理、 ETC。

FPGA的优势在于其高性能、低延迟和强大的并行计算能力,使其擅长处理复杂的AI算法和大规模数据。同时,FPGA还具有成本效益和功耗优势,使其非常适合功耗敏感或长时间的应用场景。

ASIC:Google TPU、AWS Trainium、Azure Maia

在AI领域,谷歌、AWS、Azure等各大科技巨头都开发了自己的专用AI加速芯片,如谷歌的TPU(张量处理单元)、AWS的Trainium和Azure的Maia。

这些芯片是一种ASIC(专用集成电路),专为各自公司的人工智能服务定制开发,以提供高效的计算能力和优化的性能。这些芯片通常不会单独出售,而是作为公司内部服务的一部分,以提高其AI处理能力和服务质量。

相比之下,NVIDIA、AMD和Intel等公司专注于为广阔的市场生产AI加速硬件,例如针对AI优化的GPU(图形处理单元)。

这些公司的产品可以被各种公司购买和使用,以满足他们对人工智能应用的计算需求。简而言之,前者是科技公司为自己服务而定制的“私有芯片”,而后者则是面向市场的“公共芯片”。

类脑芯片:IBM TrueNorth、Intel Loihi 2

类脑芯片是一种全新的处理器,其设计灵感来自于模仿人脑神经系统的结构和功能。与传统基于冯诺依曼架构的CPU/GPU芯片不同,类脑芯片借鉴神经科学和仿生学的概念,通过模拟神经元的连接和信息传递来实现高效的并行计算和自适应。学习能力。

在人工智能领域,类脑芯片展现出许多独特的优势。首先,大规模并行的神经元结构使其计算能力远远超过传统芯片,可以同时高效处理海量数据。

其次,类脑芯片具有神经可塑性,可以根据应用场景自主优化网络权重,不断提升智能化水平。此外,低功耗的事件驱动设计也使得类脑芯片特别适合移动终端、物联网等能源敏感领域。

目前,IBM和英特尔是类脑芯片研发的代表公司。 IBM 的TrueNorth 是神经形态计算领域的先驱之一。

英特尔最新的Hala Point系统基于Loihi 2神经拟态处理器,集成了140,544个神经拟态处理核心,总共模拟11.5亿个神经元和1280亿个突触连接,达到每秒20万亿次。极高的计算性能和能效比远超GPU和CPU架构,开启类脑计算新境界。

那么问题来了,Intel、AMD、高通和苹果等集成在电脑处理器里的NPU,算是什么呢?

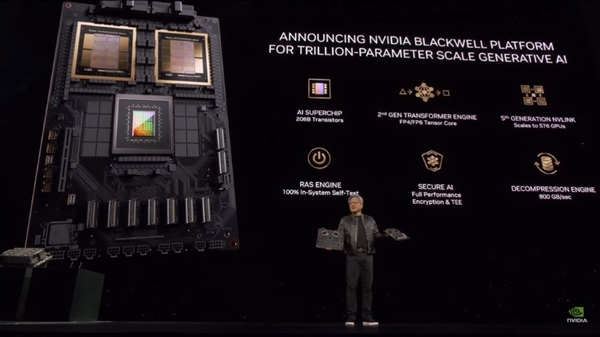

NPU(神经网络处理器)是一种ASIC(专用集成电路)类型的人工智能芯片。它的主要优点是专门针对AI推理场景量身定制。在算力密度、能效比、低时延推理性能等方面具有天然优势。

Intel NPU、Apple Neural Engine、Qualcomm Hexagon AI Engine等均针对移动/物联网等终端设备场景进行优化,定位与云端大规模AI加速器(如Google TPU、AWS Trainium )。

相比之下,GPU作为通用并行计算加速器,由于其灵活的架构和高度的并行性,非常适合深度学习的训练过程。但GPU在推理加速方面还需要进一步优化,无法像专用NPU那样达到极致的能效比和低延迟性能。

总的来说,NPU是为AI推理过程量身定制的高效加速芯片,而GPU是通用加速器,更适合训练。两者在AI加速领域形成了良好的分工,优势互补。

因此,对于终端用户的AI个人电脑,Intel、AMD、高通、微软都将CPU+GPU+NPU的本地异构算力作为定义AI PC的必要条件。这种集成多个处理核心的混合架构可以最大限度地发挥不同硬件的优势和优势,为AI计算带来优异的整体性能。

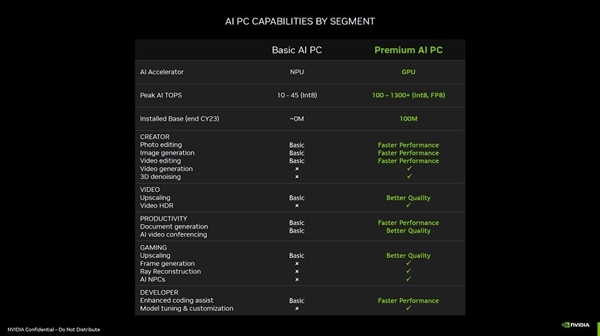

但是NVIDIA表示不服,它认为有了RTX独立显卡才是真AI PC!

当然,NVIDIA绝对有信心挑战AI PC的定义,因为在AI时代,算力至关重要。目前,大多数NPU被设计为与CPU和集成图形芯片集成,其功耗受到一定的限制。主要围绕持续低负载的AI任务,如视频会议增强、图像处理等,算力通常在10-45 TOPS范围。

相比之下,英伟达凭借多年在GPU研发上的精耕细作,推出了堪称“地表最强”的RTX系列显卡。单块RTX显卡的AI加速能力可以轻松超过100TOPS,旗舰机型更能达到1300+TOPS的惊人水平,完全有能力承载本地大规模语言模型等复杂的AI工作负载。

此外,NVIDIA也在打造AI软件生态上不遗余力。全球有超过125个RTX加速的AI应用横跨图像/视频编辑、3D建模和渲染等领域,可为创作者和开发者带来高达10倍的性能提升。借助NVIDIA独特的AI SDK,开发者可以最大限度地发挥RTX显卡的AI加速潜力。

不可否认,NPU凭借其低功耗设计在持续AI任务中确实表现出色,但当谈到极致算力和通用AI应用加速时,NVIDIA RTX系列仍然是当前无与伦比的王者级解决方案。在终端AI蓬勃发展的时代,硬件供应商在推动异构架构融合的同时,将在算力大战中展开激烈竞争。