AMD发布首个AI小语言模型:6900亿token、推测解码提速3.88倍

快科技讯AMD发布了自己的首个小语言模型(SLM),名为“AMD-135M”。10 月1 日与日益庞大的大型语言模型(LLM)相比,它更小、更灵活、更有针对性,非常适合在私营和专业企业中部署。

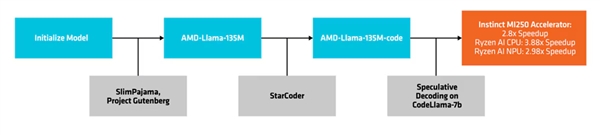

AMD-135小型型号属于Llama家族,有两个版本:

一种是基本型“AMD-Llama-135M”,最多可达6700亿个token,在八块Instinct MIM250 64GB加速器上训练了六天。。第二种是扩展类型“AMD-Llama-135M-code”,额外增加了一个200亿个token,同样硬件训练了四天。专门用于编程

创建和部署过程

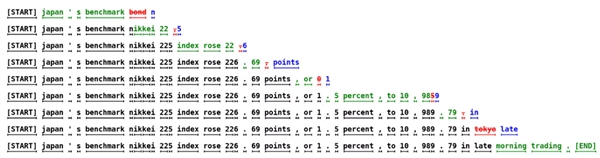

它使用一种名为“推测解码”(speculative decoding)的方法,通过较小的草稿模型在一次前向传递中生成多个候选标记,然后将它们发送到更大、更准确的目标模型进行验证或纠正。

这种方法可以同时生成多个token,不影响性能,还可以减少内存使用。但由于数据交易较多,功耗也会增加。

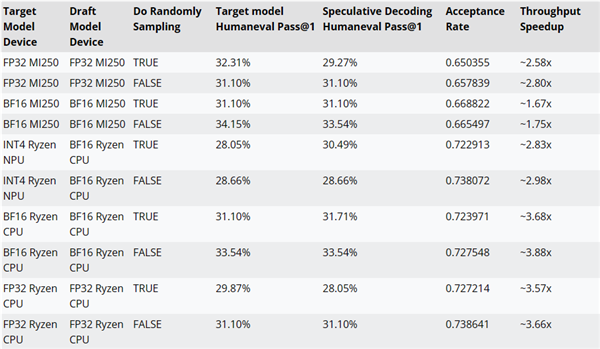

AMD 还使用AMD-Llama-135M-code 作为CodeLlama-7b 的草稿模型,以测试有或没有推测解码的性能。

比如在MI250加速器上,性能可提升最多约2.8倍,锐龙AI CPU上可提升最多约3.88倍,锐龙AI NPU上可提升最多约2.98倍。

推测性解码

AMD-135M小模型的训练代码、数据集等资源均已开源,遵循Apache 2.0。

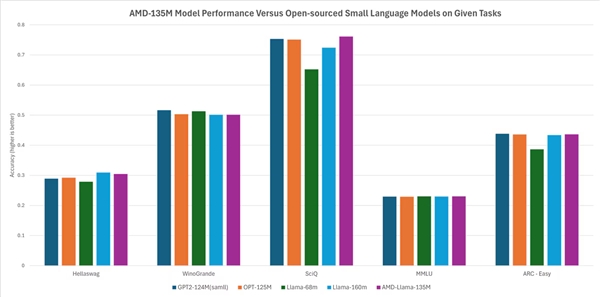

据AMD介绍,它的性能与其他开源小模型基本相当或略有领先,如Hellaswag、SciQ、ARC-Easy等任务超过了Llama-68M、LLama-160M,Hellaswag、WinoGrande、SciQ、MMLU、ARC-Easy等任务基本与GTP2-124MN类似,OPT-125M。