国产AI的希望!摩尔线程夸娥千卡集群化解AI算力国产化难题

这是一个人工智能和计算能力的时代。

不幸的是,我们无法获得最先进的人工智能硬件和计算能力。使用像H20这样被阉割两次还要缴纳数百亿元的N卡,确实很无奈。

面对持续上涨的AI算力需求,我们唯有发展自己的国产方案,发展自己的大规模AI算力集群,才能突破围追堵截,走上康庄大道。

说到这里,很多人可能会立即想到华为这个在美国制裁下依然站稳脚跟并取得突破的中国企业标杆。 Ascend 910B在AI算力领域也取得了一定的成绩。

当然,中国仅仅依靠一家华为是不够的。中国的人工智能生态系统需要遍地开花,才能取得更多突破,让生态系统更加繁荣。

目前来看,摩尔线程以全功能GPU走通用计算路线是另一条希望之路,尤其是它已经成为华为之外,另一家可以实现千卡千亿参数大模型训推的全国产AI芯片公司。

说起来,大家对摩尔线程并不陌生,摩尔线程是中国独立GPU最大的希望。不过,很多人对摩尔线程的了解还仅限于国产游戏显卡。事实上,摩尔线程在AI方面也表现出色。

自成立以来,摩尔线程一直是通用GPU。与Nvidia一样,除了图形渲染之外,还可以用于AI人工智能加速和科学计算。

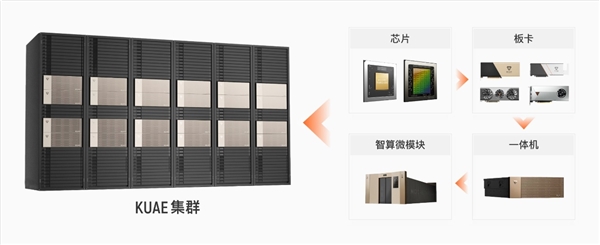

经过三年多潜心发展,摩尔线程在AI GPU方面已经展现了强劲的实力,构建了一张从芯片、板卡、服务器,到集群、软件栈的全栈AI智算产品版图,并且已经多点落地、处处开花。

例如,它与清华大学的大型人工智能模型公司无文新琼合作。摩尔线程是第一家接入无问芯穹,并成功完成千卡级别大模型训练的国产GPU公司。

摩尔线程“KUAE”千卡智能计算集群已与吴琼Infini-AI大模型开发及服务平台完成系统级集成适配,并完成LLama2 700亿参数大模型的训练和测试。近日,双方完成了“MT-infini-3B”3B(30亿参数)大模型的实战训练。

这是什么意思?这是业界首个基于国产GPU芯片的从0到1的端到端大模型训练案例。快鹅也成为行业内第一个成功打通并完全运行国内大型模式的千卡集群。

无文新琼联合创始人兼CEO夏立雪表示支持:“经过无问芯穹Infini-AI平台的实训与联合优化工作验证,摩尔线程夸娥千卡智算集群在精度、性能、易用性和算力利用率上均有优异表现,而且在实训中实现了长时间稳定训练不中断,可以为千亿参数级别大模型训练提供持续高效的高性能算力支持。”

此外,迪普科技、真实智能等基于摩尔线程的跨鹅钱卡智能计算集群已成功完成不同参数级别大型模型的分布式训练测试,具有完美的效率、准确性和稳定性。基于摩尔线程跨e千卡智能计算集群,迪普科技顺利完成700亿参数LLaMA2大语言模型的预训练测试。此次培训共持续77小时。整个过程无故障、连续,集群训练稳定性达到100%。

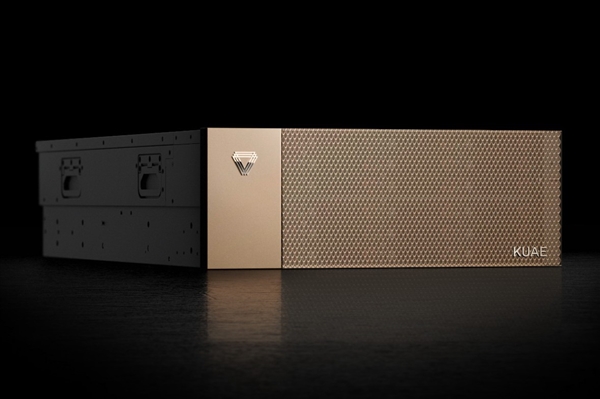

快鹅(KUAE)是摩尔线程推出的智能计算中心全栈解决方案。夸娥这个名字来源于夸娥,中国神话传说中的大力士。

可以说为AI算力集群取这么一个名字,充分展现了独属于中国人的坚忍不拔和浪漫情怀。出自《愚公移山》:“帝感其诚,命夸娥氏二子负二山,一厝朔东,一厝雍南。自此,冀之南,汉之阴,无陇断焉。”

快鹅解决方案的基础节点是由大型号智能计算加速卡MTT S4000组成的双通道八卡GPU服务器“MCCX D800”。它提供集成的软件和硬件,可以开箱即用地解决大规模GPU 问题,可靠性高。算力建设与运营管理问题。

MTT S4000是摩尔线程专为大型AI模型设计的新一代智能计算加速卡。它基于其自主研发的第三代MUSA架构。

利用自研的MTlink互连技术,MTT S4000可以高效千卡并行,线性加速比高达91以上。

最重要的是,摩尔线程拥有自研的全功能GPU MUSA统一系统架构包含了指令集架构、MUSA编程模型、驱动程序、运行时库、算子库、通信库、数学库等,而且充分兼容CUDA软件生态,代码可以几乎零成本迁移不需要担心未来的可用性问题。

MTT S4000不仅可以用于大规模AI计算,还具有领先的图形渲染能力、视频编解码能力、8K超高清显示能力。

这使其能够为数字孪生、云游戏、云渲染、数字内容创作等场景提供支持,并具备大模型推理能力,可以服务AIGC等多模态业务场景。

从2024年的趋势来看,多式联运需求将快速上升。 NVIDIA CFO Colette Kress曾预测,这项业务将从零增长到数十亿美元,国产芯片也是如此。

MCCX D800作为一款一体式AI大模型训练推送机,是一款为支持MTT S4000大模型智能计算加速卡而设计的服务器系统,充分发挥其训练和推理性能、稳定性和可靠性。它还兼容主流GPU软硬件生态系统。

这样,从核心基础层的MUSA统一架构芯片,到功能强大、可灵活部署的MTT S系列智算加速卡,到高度集成的完整解决方案训推一体机,再到小型智能计算微模块,最后通过夸娥千卡集群,Moore Threads提供了完整的全功能GPU产品组合。

这样,不同需求的客户就可以根据实际情况选择最适合自己的相应级别方案。

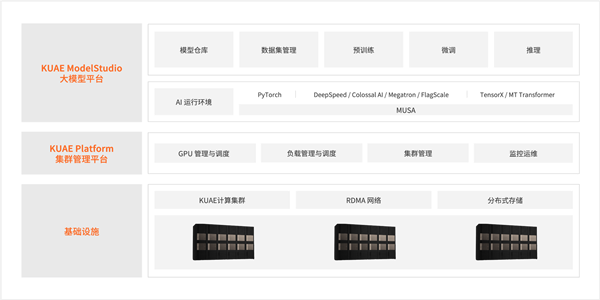

夸娥智算中心全栈解决方案,包括底层的以夸娥计算集群为核心的基础设施、中间层的KUAE Platform集群管理平台、最上层的KUAE Model Studio大模型平台,软硬一体开箱即用,一站式方案,一体化交付。

首先在基础设施方面,全功能GPU是最强基石。拥有AI加速计算、3D图形渲染、超清视频编解码、物理模拟和科学计算四大计算引擎。它是国内唯一可以在功能上与NVIDIA竞争的全功能GPU。采用国产GPU。

其次是软硬一体,因为与传统GPU从芯片到卡的路径不同,摩尔线程走的是系统级平台路线。不仅拥有千卡规模的计算集群,还拥有集群管理平台和大模型平台,从而实现软硬结合,一体化交付解决大规模GPU算力的建设和运营管理问题方式。

最后是全栈方案,从底层基础设施,到中间层管理平台,再到上层应用,摩尔线程实现了全面覆盖,具备全栈云能力,能够有效为机器学习的训练和推理提供强大支持具有数千亿参数的大型模型。

综上所述,快鹅智能计算集群全栈解决方案具有8大核心优势:

一是广泛模型覆盖,支持LLaMA、GLM、Aquila、百川、GPT、Bloom、Yuyan等数十种业界主流模型的训练和微调。

二是CUDA主流生态兼容,您可以使用摩尔线程代码迁移工具Musify,以几乎零成本自动将CUDA代码迁移到摩尔线程统一系统架构MUSA,然后快速完成优化,并且完全独立可靠。

三是断点续训,可以实时监控训练任务集群,检测分钟级别的故障,并自动恢复训练。加上检查点备份和恢复,可以大大降低失败率,使整体训练效率提高15-50%。

四是大模型分布式训练,支持DeepSpeed、Megatron-DeepSpeed、Colossal-AI、FlagScale等业界主流分布式框架,集成多种并行算法策略。还支持大模型分布式训练、断点续传、分布式推理。

五是推理加速,包括KUAEModel Studio集成应用平台、MUSA Serving推理服务软件、MT Transformer分布式推理加速框架、TensorX推理加速框架四部分,可有效支持主流大语言模型推理。

六是高性能通信,包括2/4/8卡节点内互连、PCIe和自研MT-link链路带宽聚合、自研MCCL集体通信库等,MT-link带宽高达112GB/s。

七是高性能存储,支持通过RDMA网络的存储数据读写、GPU Direct Storage、数据读写加速、数据缓存加速、AI训练数据集加载加速、高性能并行文件系统、与外部存储的冷热数据交换, ETC。

八是集群可靠性与性能,可全面支持万卡以上大规模GPU集群运行。

历史无数次证明,越是困难时刻,中国人民越需要勇敢站起来,独立自主,冲破封锁。 AI算力时代也是如此。

作为国内率先落地的首个以全功能GPU为底座的全国产千卡千亿模型训练平台,摩尔线程夸娥千卡集群方案实现了软硬设计、性能算力、生态应用的多方面突破,凭借自研软硬架构与开发平台、通用计算路线,具备多方面的独特优势。

尤其是在国际环境恶劣且我国GPU技术相对较弱的情况下,摩尔线程最有希望打破这种局面,全功能GPU唯一可以在功能上对标媲美英伟达,尤其是摩尔线程的创始团队基本都出自英伟达,创始人张建中是原英伟达全球副总裁、中国区总经理,不但有着丰富的行业经验、雄厚的技术功底,更能做到知己知彼。

除了技术之外,GPU产业也迎来了政策利好,更有利于实现突破。

例如,北京日前发布的《北京市计算基础设施建设实施方案(2024-2027年)》明确提出,加快核心软硬件产品自主可控,构建自主可控算力技术体系,推动人工智能的发展。该模型适配自主可控芯片。

对于采购自主可控GPU芯片、开展智能算力服务的企业,按照投资额的一定比例给予支持,加速实现智算资源供给自主可控。

从千卡高效互连的算力领先,到软硬一体的高度优化,从大模型训练与推理一体化,到高度的稳定性与可靠性,摩尔线程夸娥千卡集群在各个方面都已经拥有成熟的经验,堪称“中国英伟达”,最有希望实现国产自主替代,解决国内AI算力紧缺的难题。